KI Bildgenerierung

Vom Rauschen zum Bild

KI Bildgenerierung

Künstliche Intelligenz (KI) prägt zunehmend kreative Prozesse, insbesondere in der Bildgenerierung. Sie taucht mittlerweile häufig in den sozialen Medien, der Werbung oder in Nachrichten auf, wobei ihre Herkunft oft nicht eindeutig zu erkennen ist. Wer jedoch versteht, wie solche Bilder technisch entstehen, kann ihre Glaubwürdigkeit besser einschätzen und entwickelt ein kritisches Bewusstsein im Umgang mit digitalen Inhalten. Dieses Verständnis ist eine wesentliche Voraussetzung für moderne Medienkompetenz.

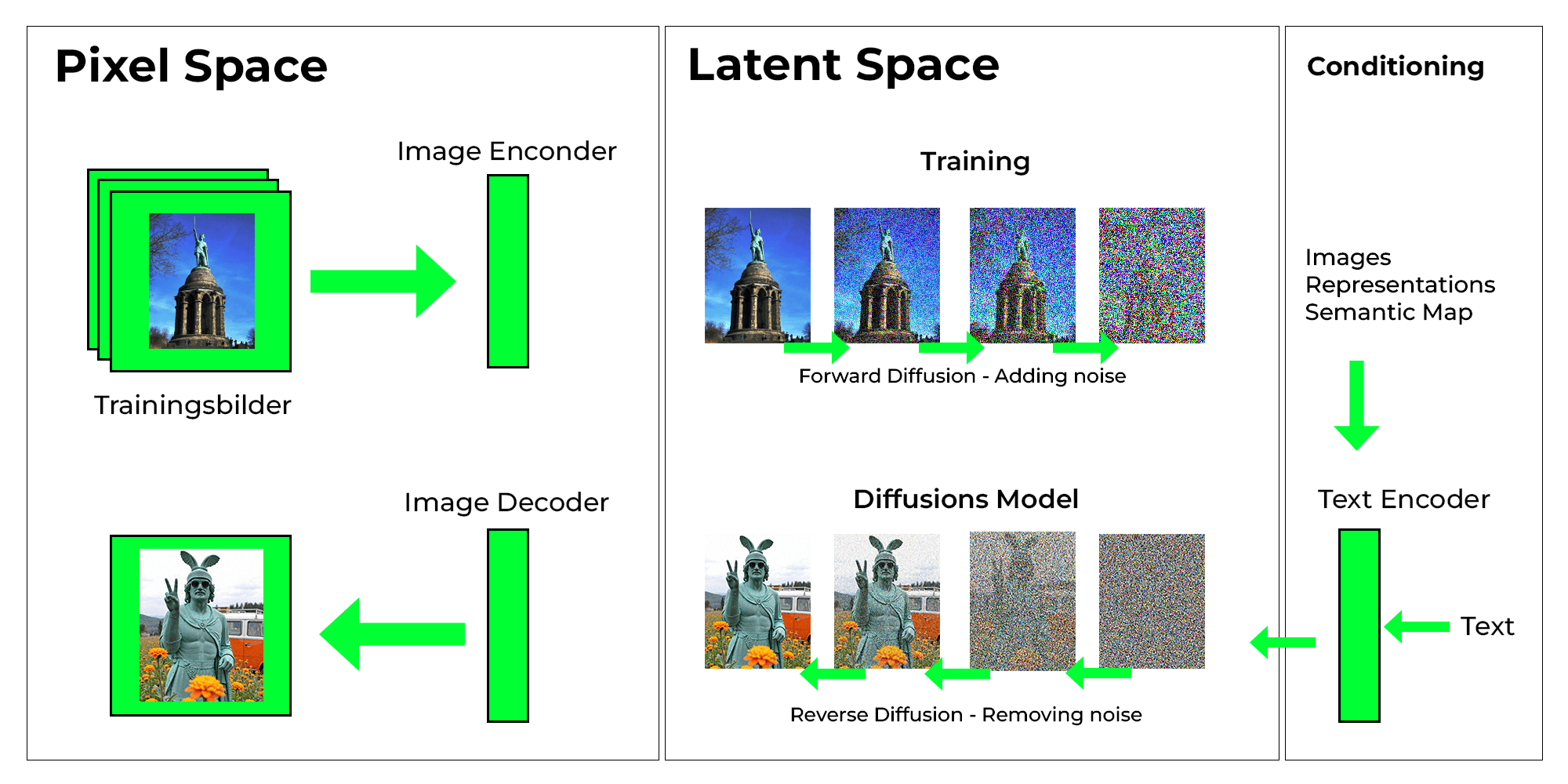

Die heute am weitesten verbreitete Methode zur KI-Bildgenerierung basiert auf sogenannten Diffusionsmodellen. Diese Modelle, wie zum Beispiel Stable Diffusion , erzeugen Bilder, indem sie ein anfänglich zufälliges Rauschen schrittweise in ein visuell sinnvolles Bild umwandeln. Der Vorgang beginnt mit reinem Rauschen: einem Bild ohne erkennbare Struktur. In mehreren Schritten sagt das Modell bei jedem Durchlauf voraus, welche Bildinformationen sich unter dem Rauschen verbergen, und rekonstruiert so ein zunehmend klareres Bild. Gesteuert wird der Prozess häufig durch einen beschreibenden Text, den sogenannten Prompt. So entstehen nach und nach Konturen, Formen, Texturen und schließlich ein vollständiges Bild.

Dieser Prozess basiert auf einem Training, bei dem das Modell lernt, wie sich Rauschen in Bilder umwandeln lässt. Während des Trainings fügt das System realen Bildern schrittweise Rauschen hinzu und übt, diesen Vorgang rückgängig zu machen. In der Anwendung beginnt es mit Rauschen und rekonstruiert daraus schrittweise ein realistisch wirkendes Bild. Eine Bildreihe veranschaulicht diesen Ablauf und zeigt, wie aus chaotischem Rauschen ein detailreiches KI-Bild entsteht.

Neben Diffusionsmodellen gibt es weitere Ansätze.Generative Adversarial Networks (GANs) entstehen aus zwei konkurrierenden Netzwerken: Ein Generator erzeugt Bilder, ein Diskriminator beurteilt deren Echtheit . Durch Rückmeldung lernt der Generator, immer überzeugendere Bilder zu erstellen. GANs waren lange der Standard, gelten aber heute als weniger stabil. Ein häufiges Problem ist der sogenannte Modus-Kollaps. Dabei produziert der Generator nur wenige ähnliche Bildvarianten statt vielfältige Ergebnisse.

Autoregressive Modelle generieren Bilder schrittweise, wobei jedes neue Bildelement auf dem bereits vorhandenen aufbaut. Das Bild wird dabei in kleine Abschnitte (Patches) zerlegt, die nacheinander berechnet werden. Die Methode ist vollständig promptbasiert, da alle Entscheidungen auf dem eingegebenen Text beruhen. Neuere Entwicklungen wie ControlAR oder TensorAR zeigen, dass sich autoregressive Modelle heute deutlich flexibler steuern lassen – etwa durch Skizzen, Tiefeninformationen oder gezielte Nachbearbeitung . Dieses Prinzip findet sich auch in modernen Anwendungen wie GPT-4o wieder, das ein autoregressives Bildmodell verwendet .

Fotografie war lange das Medium, mit dem die visuelle Wirklichkeit dokumentiert wurde – ein eingefrorener Moment der Realität. KI-generierte Bilder hingegen entstehen nicht aus dem Sichtbaren, sondern aus Daten, Wahrscheinlichkeiten und sprachlichen Beschreibungen. Sie sind keine Abbilder der Welt, sondern Konstruktionen – visuelle Hypothesen darüber, wie etwas aussehen könnte.

Der deutsche Künstler Boris Eldagsen prägte und popularisierte daher im Zusammenhang mit KI-generieten Bildern den Begriff „Promptography/Promptografie“, um KI-Bilder klar von klassischer Fotografie abzugrenzen („Photography is writing with light; promptography is writing with prompts.“) . Der Begriff wird in Debatten, Interviews und von Eldagsen selbst verwendet, u. a. im Kontext seiner Sony-Award-Ablehnung 2023, mit der er die Kategorisierung von KI-Bildern zur Diskussion stellte.

Ein Prompt ist eine Texteingabe, mit der man ein KI-Modell dazu auffordert, ein Bild zu erzeugen oder zu verändern. Er ist die zentrale Steuerung: Der Prompt legt fest, was dargestellt wird, wie es aussieht und welche Atmosphäre das Bild vermitteln soll.

Im Hintergrund arbeitet das Modell mit einem sogenannten latenten Raum. Dieser lässt sich als abstrakte Repräsentation des gelernten visuellen Wissens verstehen. Er enthält Informationen über Formen, Farben, Perspektiven, Stile und Zusammenhänge. Der latente Raum ist nicht direkt sichtbar, bestimmt aber maßgeblich, welche Möglichkeiten der KI bei der Bildgenerierung zur Verfügung stehen.

Ein präzise formulierter Prompt hilft dem Modell, sich in diesem Raum zu orientieren und gezielt die Bereiche zu aktivieren, die zum gewünschten Bild führen. Je konkreter und strukturierter die Eingabe, desto wahrscheinlicher ein passendes Ergebnis. Vage Prompts führen hingegen häufiger zu ungenauen oder zufälligen Resultaten.

Kurz gesagt: Der Prompt ist die Sprache, mit der wir mit der KI kommunizieren – und der latente Raum ist das Gedächtnis, in dem sie ihr Wissen über die visuelle Welt gespeichert hat.

Wie setzt sich aber nun ein Prompt zusammen und wie lässt sich damit eine Bildgenerierungsmodell gezielt steuern?

Zwischen sehr kurzen Anweisungen („Minimalprompts“) und detaillierte Anweisungen liegt ein breites Spektrum an Kontrolle: Man kann der KI bewusst großen Freiraum lassen oder das Ergebnis sehr genau vorgeben. Etwas vage formulierte Prompts eignen sich meistens eher für explorative Phasen oder Moodboards, bei denen Vielfalt und überraschende Vorschläge erwünscht sind.

Ein guter Bild-Prompt basiert in der Regel auf zwei Ebenen:

So wird der latente Raum gezielt aktiviert. Je klarer der sprachliche Anker, desto gezielter bewegt sich die KI in Richtung des gewünschten Ergebnisses.

Eine bewährte Struktur für die Formulierung eines Promptes lautet z.B.: [Motiv] + [Komposition] + [Details] + [Hintergrund] + [Medium]+ [Farben] + [Licht] + [Stimmung] + [Stil] + [Format], ergänzt um Negativ-Prompts, Seed und weitere Parameter.

Der Arbeitsprozess bei der Erstellung von KI-Bildern ist sehr iterativ: Zunächst wird die Kernidee formuliert, dann werden erste Ergebnisse generiert, ausgewählt, gezielt verfeinert und abschließend anhand der definierten Ziele überprüft und in der Regel noch weiter z.B. in Bildbearbeitungtools verarbeiten.

Neben der technischen Umsetzung sind auch rechtliche und ethische Aspekte zu beachten (→ Lizenz zum Training): Urheber-, Marken- und Persönlichkeitsrechte, Datenschutz sowie die Kennzeichnungspflicht für KI-generierte Medien (→ Alles nur Fake?) spielen gerade bei Personen- und Produktdarstellungen eine zentrale Rolle.

| Prompt | "kio-hermann statue sitting in a fast food restaurant, holding a burger, wearing his historical armor, bronze statue style, fluorescent lighting, red and yellow interior, cinematic photograph" |

| Modell | Flux [dev] |

| Seed | 546762133477920 |

| Step | 25 |

Trotz technischer Fortschritte zeigen KI-Bilder häufig typische Fehler. Eine Studie von Kamali et al. (2024) teilt diese in fünf Kategorien ein :

Solche Fehler entstehen, weil das Modell keine echte Vorstellung von der Welt besitzt. Es basiert auf statistischen Wahrscheinlichkeiten. Kombiniert mit einseitigen Trainingsdaten kann dies zu stereotypen oder verzerrten Darstellungen führen. Auf den Prompt „Arzt“ folgt oft das Bild eines älteren weißen Mannes im Kittel. Das liegt nicht an der Neutralität des Begriffs, sondern an der Häufigkeit solcher Darstellungen in den Trainingsdaten. Dieses Phänomen wird als Trainingsbias bezeichnet .

KI-generierte Bilder werden immer realistischer und lassen sich zunehmend gezielt steuern. Während Diffusionsmodelle aktuell den Standard setzen, zeigen auch autoregressive Ansätze, wie rasant sich die Technologie weiterentwickelt. Dennoch bleiben typische Fehler und subtile Hinweise erhalten, die KI-generierte Bilder von echten unterscheiden. Zukünftige Entwicklungen könnten diese Unterscheidung immer schwieriger machen. Umso wichtiger wird es, technische Zusammenhänge zu verstehen und die Bildgenerierung kritisch zu hinterfragen. Je informierter wir mit KI umgehen, desto besser gelingt es uns, deren kreative Potenziale zu nutzen, ohne dabei die Risiken aus dem Blick zu verlieren.

KI-Bilder sind immer abhängig von ihren Trainingsdaten

Die Qualität und Aussagekraft KI-generierter Bilder hängen entscheidend von den Daten ab, mit denen die KI trainiert wurde. Je vielfältiger und ausgewogener diese Trainingsdaten sind, desto realistischer und weniger voreingenommen sind die Ergebnisse.

Unterschiedliche KI-Modelle haben spezifische Stärken und Schwächen

Diffusionsmodelle ermöglichen präzise Steuerung und realistische Ergebnisse, sind jedoch rechenintensiv. Autoregressive Modelle sind effizient und promptbasiert, bislang aber weniger flexibel steuerbar – neuere Ansätze verbessern dies jedoch zunehmend.

KI-Modelle reproduzieren oft gesellschaftliche Stereotype

Da Trainingsdaten aus vorhandenen Bildern bestehen, verstärken KI-Systeme häufig bestehende Vorurteile oder stereotype Darstellungen – etwa, indem sie bei der Eingabe „Arzt“ bevorzugt einen älteren weißen Mann darstellen.

Typische Fehler entlarven KI-generierte Bilder

KI-Bilder zeigen trotz realistischer Optik oft subtile Fehler, wie anatomische Verzerrungen, glatte Oberflächen, falsche Schatten oder funktional unpassende Objekte. Solche Merkmale helfen dir, KI-generierte Bilder von echten Bildern zu unterscheiden.

Wissen über KI-Bildgenerierung stärkt deine kritische Wahrnehmung

Wer erkennt, wie KI Bilder erzeugt und welche typischen Auffälligkeiten auftreten, betrachtet visuelle Inhalte in sozialen Medien automatisch skeptischer und bewusster. Das schützt vor Manipulation und Falschinformationen im digitalen Alltag.

abgerufen am 08.08.2025

Pressemitteilung

Download