ZWISCHEN WAHRHEIT UND ILLUSION

Alles nur Fake?

ZWISCHEN WAHRHEIT UND ILLUSION

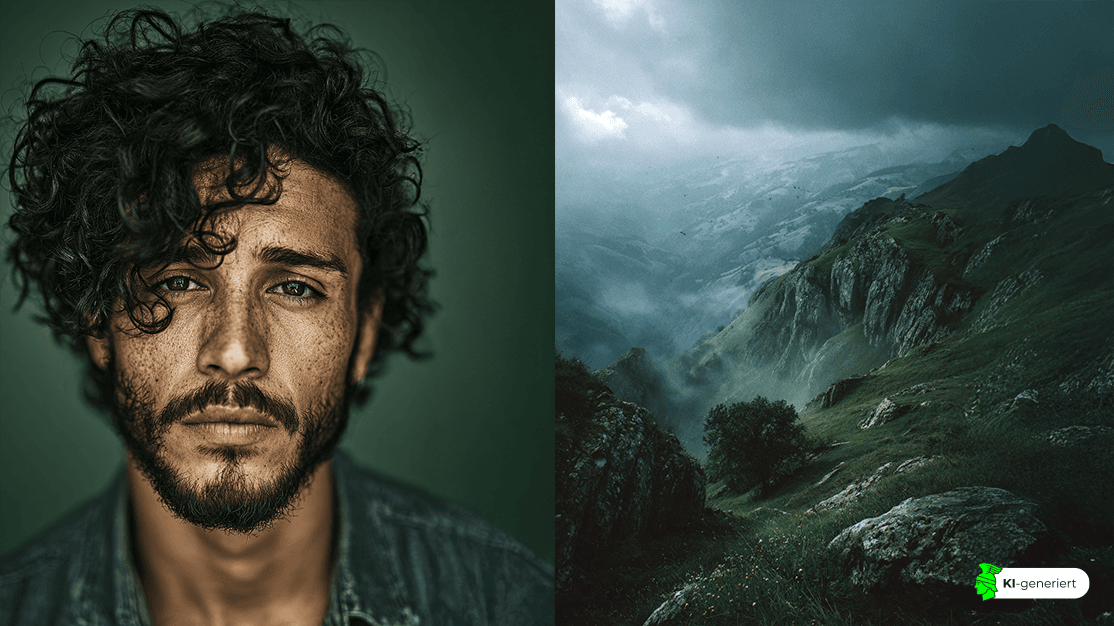

In Zeiten generativer KI verschwimmen Realität und Simulation mehr denn je. Was wir sehen – und auch hören oder lesen – ist längst nicht mehr das, was „wirklich“ ist. Täuschend echte Deepfakes, KI-generierte Memes und manipulierte Bilder prägen unsere alltägliche Wahrnehmung der Realität. Mehr denn je müssen wir lernen, Bildern nicht blind zu vertrauen, sondern kritisch, kontextbewusst und reflektiert hinzusehen.

Wir leben in einer Welt, die vom Visuellen durchdrungen ist. Fotografien, Videos und das Bildliche sind allgegenwärtig, sie begleiten unseren Alltag, ob als Nachrichtenbilder, Social-Media-Posts oder Werbeanzeigen. Und doch: Trotz ihrer Allgegenwart und dem vermeintlichen Bewusstsein ihrer manipulativen Kraft, genießen sie einen gewissen Vertrauensvorschuss, den wir Texten längst abgeschrieben haben . Das Bild gilt vielen noch immer als unmittelbares Abbild der Realität, als objektive Spiegelung des „Wirklichen“. Doch dieser Glaube ist trügerisch und war es eigentlich schon immer. Bereits in analogen Zeiten wurden Bilder manipuliert, z.B. zu Propagandazwecken. Aber auch schon die Auswahl des Bildausschnitts, der Moment der Aufnahme, die Perspektive, all das sind bewusste Entscheidungen, die Realität formen, nicht wirklich abbilden.

Heute jedoch, im modernen Informationszeitalter und durch die disruptiven Entwicklungen rund um künstliche Intelligenz, hat sich die Dimension der digitalen Bildmanipulation nochmal radikal verschoben. Während früher aufwendige chemische Prozesse und tagelange professionelle Retusche nötig waren, reicht heute häufig ein kurzer Textbefehl (Prompt). Text-to-Image-Modelle wie z.B. Midjourney oder Stable Diffusion generieren aus einfachen Prompts in Sekunden realistisch wirkende Bildwelten. Billionen von Webfotos dienen dabei als Rohmaterial, während neuronale Netze lernen Objekte, Texturen, Licht und Komposition so perfekt rekonstruieren, dass oft nicht mehr erkennbar ist, wo Realität endet und Simulation beginnt.

Generative KI wird hier zum Meister der Nachahmung unserer medialisierten Wirklichkeit.

Der französische Medientheoretiker Jean Baudrillard sprach bereits in den 1980er-Jahren von „Simulacra“ – Abbildern ohne Ursprung –, die glaubhafter erscheinen als die Realität selbst. Zwar bezog er sich noch nicht explizit auf KI-generierte Bilder, doch seine Theorie der Hyperrealität scheint heute aktueller denn je. Denn KI-Bilder „sehen“ oft wahrer aus als jene Fotografie – obwohl sie nie ein Lichtstrahl berührt hat .

Und doch scheint unser Vertrauen in das Bildliche ungebrochen. In einer Welt, in der Täuschung so mühelos geworden ist, halten wir weiterhin an der Illusion fest, dass Bilder mehr Wahrheit zeigen als Worte. Vielleicht, weil wir dem Schein des Visuellen mehr glauben wollen als der anstrengenden Komplexität der Wirklichkeit.

Die Faszination für Bilder, und unser instinktives Vertrauen in sie, ist kein Zufall. Unser Gehirn ist, wenn man so will, ein naiver Realist: Es geht ganz selbstverständlich davon aus, dass das, was wir sehen, auch wirklich so ist. Diese Grundannahme entspringt keiner Schwäche, sondern einem evolutionären Vorteil. Unsere visuelle Wahrnehmung ist auf Geschwindigkeit optimiert, nicht auf Skepsis. Statt jede visuelle Information zu hinterfragen, greifen wir auf kognitive Shortcuts zurück. Genau diese machen uns eben auch anfällig für die visuelle Überzeugungskraft von u.a. KI-generierten Bildern: Zum Beispiel der Mere-Exposure-Effekt und der Source-Monitoring-Error.

Der Mere-Exposure-Effekt, beschrieben vom Sozialpsychologen Robert Zajonc im Jahr 1968, besagt: Was wir häufig sehen, erscheint uns vertrauter und Vertrautheit verwechseln wir schnell mit Wahrheit. In sozialen Medien führt das dazu, dass KI-generierte Gesichter, die uns immer wieder begegnen, irgendwann „echt“ wirken – nicht, weil wir sie überprüft haben, sondern weil sie sich bekannt anfühlen.

Der zweite Mechanismus, der sogenannte Source-Monitoring-Error, wurde von der Kognitionspsychologin Marcia K. Johnson in den 1990er-Jahren untersucht. Er beschreibt unsere Schwierigkeit, im Nachhinein korrekt zu erinnern, woher eine Information stammt: aus eigener Erfahrung, Erzählung oder Medien. Besonders bei Bildern verschwimmt diese Quelle oft: Haben wir das selbst erlebt? Oder nur gesehen, in einem Feed, einem Video, einem Post?

Beide Effekte treffen im digitalen Raum mit voller Wucht aufeinander: Wiederholung erzeugt Vertrautheit, Vertrautheit erzeugt Glauben – und unsere Erinnerung ist anfälliger, je flüchtiger der Kontext ist. Mit KI-Bildern werden diese kognitiven Abkürzungen gezielt ausgenutzt: Sie wirken plausibel, weil sie genau an jene Stellen im Gedächtnis andocken, wo Unschärfe herrscht – emotional, wiederholt, vertraut. Und das macht sie gefährlich überzeugend.

Wir glauben manchmal, die Welt sei so, wie wir sie wahrnehmen und blenden aus, dass Wahrnehmung stets selektiv und subjektiv ist. Einige Anwender:innen von künstlicher Intelligenz machen sich diese kognitive Verzerrung zunutze: Denn mit KI können Bilder erzeugt werden, die nicht nur realistisch aussehen, sondern sich auch real „anfühlen“. Und sobald Emotionen ins Spiel kommen – ob Überraschung, Empörung oder Freude übernimmt das schnelle, intuitive Denken, das Daniel Kahneman als System 1 beschreibt. Das langsame, analytische Denken (System 2) hingegen schaltet sich oft zu spät ein – oder gar nicht.

Das eigentliche Problem liegt also nicht primär in der Technologie, sondern in unserer Reaktion und Verarbeitung darauf und wie die Anwender von KI-Tools sich dieser Fähigkeiten zu eigen machen. KI-generierte Bilder sind u.a. so wirkungsmächtig, weil wir sie (manchmal) so bereitwillig akzeptieren.

Künstliche Intelligenz ist nicht von sich aus manipulativ, auch wenn das durch die Medien und deren Framing häufig suggeriert wird. Doch in den Händen derer, die sie strategisch einsetzen, wird sie zum Werkzeug machtvoller Inszenierung. Denn KI-Bilder sind längst nicht nur noch „Fakes“ – sie sind Narrative-Booster, die gezielt auf Emotionen, Erwartungen und kollektive Deutungsmuster zielen. Sie funktionieren nicht isoliert, sondern eingebettet in politische, kulturelle und mediale Kontexte. Und genau darin liegt ihr Einfluss.

Ein brennendes Parlament, eine dramatische Verhaftung, ein angeblicher Kriegsschauplatz – synthetische Motive wirken, weil sie Narrative visuell verdichten, bevor die Fakten überhaupt Fuß fassen können. Diese Form der visuellen Desinformation wird auch Memetic Warfare genannt: Memes sind, wenn man so will, visuelle Granaten – sie schlagen ein, bevor Fakten greifen können.

Ein Beispiel: Im März 2023 kursierten täuschend echte Bilder von Donald Trumps angeblicher Verhaftung, erstellt mit dem KI-Tool Midjourney. Binnen Stunden gingen sie viral, geteilt von Gegnern wie Unterstützern. Obwohl frei erfunden, wirkten sie visuell plausibel und emotional stark – und dienten so als Projektionsfläche in einem aufgeheizten politischen Klima.

Laut Analysen von Sensity AI und der Konrad-Adenauer-Stiftung nehmen politische Deepfakes in Wahljahren deutlich zu. Nicht nur, weil die Technologie besser wird, sondern weil sie gezielt eingesetzt wird, um Meinungen zu beeinflussen und Deutungshoheit zu gewinnen.

Verstärkt wird diese Wirkung durch die Funktionsweise sozialer Medien. Plattformen wie TikTok, Instagram oder X operieren nach einem simplen Prinzip: Aufmerksamkeit zählt mehr als Wahrheit.

Die Dynamik sozialer Medien verstärkt diesen Effekt auf mehreren Ebenen. Das hohe Tempo des digitalen Bildkonsums – Scrollen, Swipen, Weiterklicken – lässt kaum Raum für Einordnung. Unsere Aufmerksamkeit wird fragmentiert, Inhalte fluten im Sekundentakt durch unsere Feeds. Inmitten von TikTok-Loops, Insta-Stories und Doomscrolling verschmelzen Original und Fälschung zu einer neuen Ästhetik des Glaubhaften.

Gleichzeitig filtern algorithmische Systeme vor, nicht nach Wahrheitsgehalt, sondern nach emotionaler Relevanz. Was wütend, empört oder ergriffen macht, wird bevorzugt ausgespielt. So entstehen digitale Filterblasen die nicht nur selektieren, was sichtbar wird, sondern auch, wie wir es wahrnehmen. Die Wiederholung verstärkt den Effekt: Vertrautheit fühlt sich richtig an – auch wenn der Inhalt falsch ist.

Das Problem liegt also weniger in den KI-generierten Erzeugnissen selbst als in dem gesellschaftlichen und medialen Umfeld, in dem sie entstehen und wirken. In einer Medienlogik, die Emotion über Information stellt. In einem Wahrnehmungssystem, das auf Geschwindigkeit statt Skepsis optimiert ist. Und in einem digitalen Ökosystem, das Wahrheit nicht belohnt, sondern eher virale Reichweite. KI ist per se erstmal neutral – doch sie lernt aus Daten, die alles andere als neutral sind.

Künstliche Intelligenz reproduziert nicht nur Vorhandenes – sie reproduziert die digitale Voreingenommenheit, wie sie im Internet millionenfach dokumentiert ist. Und damit oft auch: das Unsichtbare. Was nicht in den Trainingsdaten auftaucht, wird nicht gezeigt oder verzerrt wiedergegeben. So entscheiden letztlich jene, die die Datenbasis kuratieren, darüber, welche Wirklichkeiten sichtbar werden und welche weiterhin ausgeblendet bleiben. Denn was sichtbar wird, hängt immer auch davon ab, wer die KI trainiert hat, mit welchen Datensätzen und auch Absichten. Das Bias (Verzerrung) in KI-Systemen erklärt, warum der Prompt „CEO“ meist weiße Männer generiert oder der Begriff „Held“ bevorzugt männlich erscheint.

Mit dem im Frühjahr 2024 verabschiedeten EU AI Act wurde erstmals eine umfassende gesetzliche Grundlage für den Umgang mit künstlicher Intelligenz geschaffen. Eine der zentralen Regelungen: KI-generierte Inhalte müssen in bestimmten Kontexten klar gekennzeichnet werden, etwa wenn es sich um synthetische Bilder, Stimmen oder Videos handelt, die potenziell täuschen oder manipulieren können.

Parallel dazu entstehen privatwirtschaftliche Standards wie die Content Credentials Initiative (u.a. entwickelt von Adobe und Microsoft). Sie setzt auf technische Transparenz: Metadaten zu Ursprung, Bearbeitung und KI-Einsatz werden direkt in die Dateien eingebettet – ein digitaler Herkunftsnachweis, der idealerweise auch beim Teilen über soziale Netzwerke erhalten bleibt.

Doch bis solche Systeme flächendeckend greifen und verpflichtend implementiert sind, liegt die Verantwortung weiterhin bei den Ersteller:innen selbst. Einheitliche, plattformübergreifende Standards fehlen bislang. Besonders in sozialen Medien hängt es häufig von der freiwilligen Initiative Einzelner ab, sichtbar zu machen, wo KI im Spiel war und in welcher Form. Ein durchgängiger Kennzeichnungsstandard wäre dabei nicht nur rechtlich sinnvoll, sondern auch kulturell relevant: Er würde die mediale Lesbarkeit von Bildern erhöhen und zugleich Vertrauen in den bewussten Umgang mit KI stärken.

Gleichzeitig zeigt eine Analyse der Mozilla Foundation (März 2024), dass bestehende Kennzeichnungsinstrumente wie Wasserzeichen, Labels oder Metadaten leicht manipulierbar, nicht sichtbar oder nicht konsistent anwendbar seien. Selbst dort, wo Labels existieren, würden sie von Nutzer:innen oft übersehen oder beim Teilen entfernt. Mozilla kommt daher zu einem klaren Fazit: Weder rechtliche noch technische Maßnahmen allein reichen aus. Um KI-Inhalte wirksam erkennbar zu machen, brauche es eine Kombination aus techni-scher Infrastruktur, verbindlicher Regulierung und breiter gesellschaftlicher Medienbildung. Nur durch diesen Dreiklang könne langfristig Vertrauen und Transparenz im digitalen Raum entstehen.

Im Zeitalter generativer KI konkurrieren Bilder in gewisser Weise mit der Realität selbst: Je überzeugender synthetisch erzeugte Motive ausfallen, desto rascher schwindet unser Vertrauen in das scheinbar Echte – während wir dem Künstlichen, vor allem im digitalen Raum, erstaunlich oft bereitwillig Glauben schenken. Was bedeutet das für unsere Wahrnehmung von Wahrheit? Und welchen Einfluss hat das auf eine zunehmend digitalisierte Gesellschaft? Diese Fragen verlangen nach klaren Antworten und nach einem noch bewussteren Umgang mit Bildern.

Denn: Nur Hinschauen genügt nicht mehr. Wir brauchen einen erweiterten Blick: einen, der skeptisch, datenkundig und reflektiert ist. Dieser Blick beginnt mit der Herkunftsfrage: „Woher kommt dieses Bild?“ und erst danach folgt die Wirkungsfrage: „Was macht es mit mir?“. In einer Welt der simulierten Realitäten reicht es nicht mehr aus, bloß Augenzeug:in zu sein. Wir müssen Datenzeug:innen werden. Das heißt: Jede (Bild-)Datei auf Kontext, Entstehungsbedingungen und Intention zu prüfen, anstatt sie reflexhaft zu glauben oder weiterzuleiten. Medienkompetenz wird damit zu einer der entscheidenden Zukunftsfähigkeiten des 21. Jahrhunderts.

Augenzeug:in zu sein reicht nicht mehr; wir müssen Datenzeug:innen werden. Das bedeutet: jede (Bild-)Datei auf Herkunft, Kontext und Intention prüfen, statt sie reflexhaft zu glauben oder weiterzuleiten.

Die Debatte über KI-Bilder, wie sie etwa im Artikel „Der Papst im Puffmantel ist kein Untergangsprophet“ formuliert wird, zeigt, dass wir als Gesellschaft durchaus in der Lage sind, ein neues Verhältnis zum Bild zu entwickeln. Synthetische Bilder wirken wie ein Stresstest für unsere Wahrnehmung, aber eben auch als Lernimpuls. Vielleicht müssen wir in Zukunft nicht weniger, sondern besser hinsehen.

So gelingt ein verantwortungsvoller Umgang mit KI-Bildern

abgerufen am 29.07.2025

Pressemitteilung

Download