KI-Tools + Workflows

Hermann auf Knopfdruck?

KI-Tools + Workflows

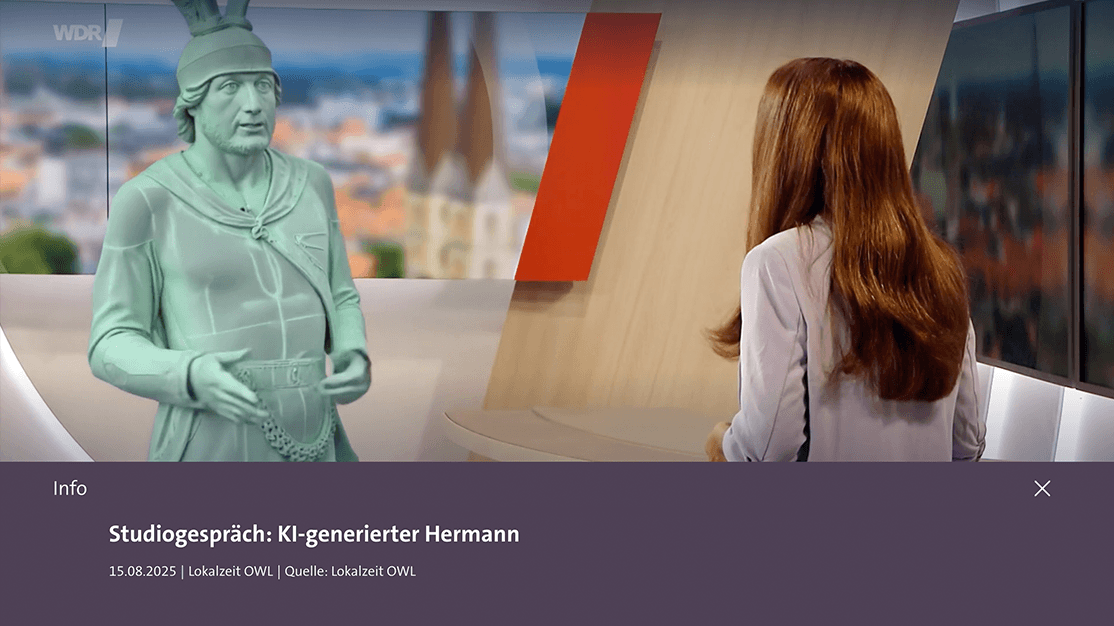

Der Hype um KI ist groß, die Versprechen oft noch größer: schnellere Ergebnisse, mehr Kreativität – und das alles scheinbar auf Knopfdruck. Doch wer selbst mit KI arbeitet, merkt schnell: Ohne klare Vorstellung und ohne präzisen Input entsteht selten das, was man wirklich braucht.

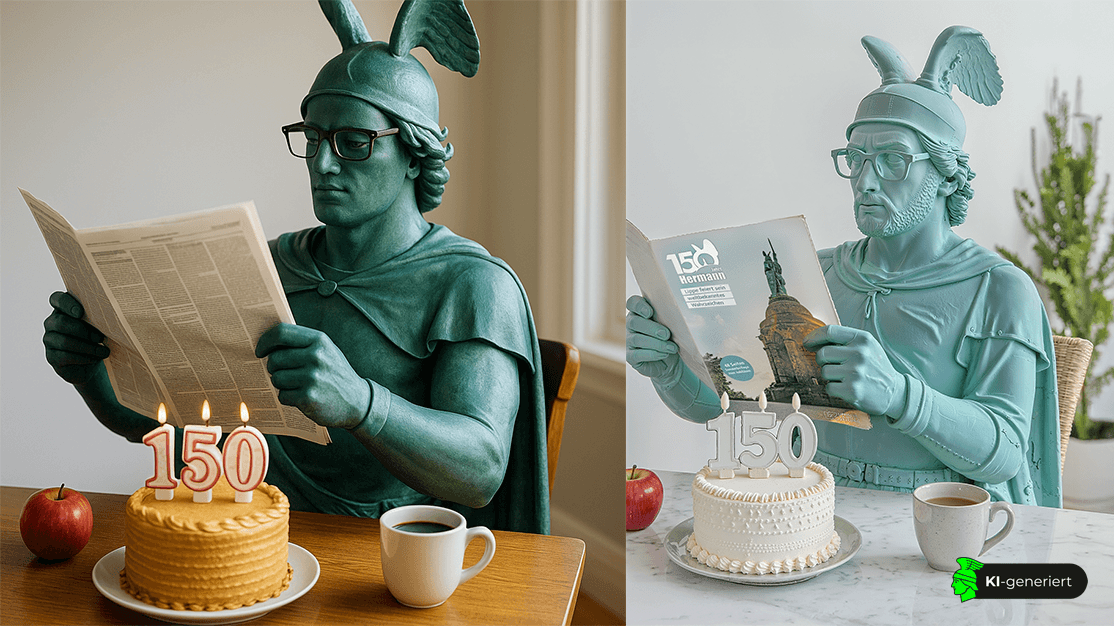

Auch unser KI-Hermann war kein Produkt per Mausklick. Hinter jedem Bild und jedem Reel stand ein Prozess: von der ersten Bildidee über zahlreiche Versuche und Iterationen bis hin zur kuratierten Auswahl. In diesem Beitrag zeigen wir, wie der KI-Hermann Schritt für Schritt entstanden ist.

Bevor der „KI-Hermann“ aus den Servern unseres Instituts auf Instagram auftauchen konnte, brauchte es ein Modell, das seine ikonische Gestalt erfasst. Wir hätten dafür auch mit ChatGPT, genauer gesagt GPT-4o, arbeiten können – ein autoregressives Bildmodell (vgl. hier). Dabei lässt sich ein Referenzbild des Denkmals hochladen und per Prompt das gewünschte Motiv beschreiben.

Dieser Prozess basiert auf einem Training, bei dem das Modell lernt, wie sich Rauschen in Bilder umwandeln lässt. Während des Trainings fügt das System realen Bildern schrittweise Rauschen hinzu und übt, diesen Vorgang rückgängig zu machen. In der Anwendung beginnt es mit Rauschen und rekonstruiert daraus schrittweise ein realistisch wirkendes Bild. Eine Bildreihe veranschaulicht diesen Ablauf und zeigt, wie aus chaotischem Rauschen ein detailreiches KI-Bild entsteht.

Um die charakteristischen Merkmale des Hermannsdenkmals präziser und realitätsnäher zu reproduzieren, haben wir ein kleines spezialisiertes Modell trainiert. Dafür nutzten wir die sogenannte LoRA-Technologie (Low-Rank Adaptation). Das Prinzip: Statt ein riesiges Modell komplett neu zu trainieren, ergänzt man es um ein leichtgewichtiges Zusatzmodul, das wie ein Plug-in funktioniert. Das spart Rechenleistung, Speicher und Zeit – ideal für fokussierte Projekte. So konnten wir ein Modell entwickeln, das das Hermannsdenkmal zuverlässig erkennt und abbildet. Alles läuft lokal bei uns im KreativInstitut.OWL – mit eigener Infrastruktur und eigenen Daten, was volle Kontrolle und Datenschutz garantiert.

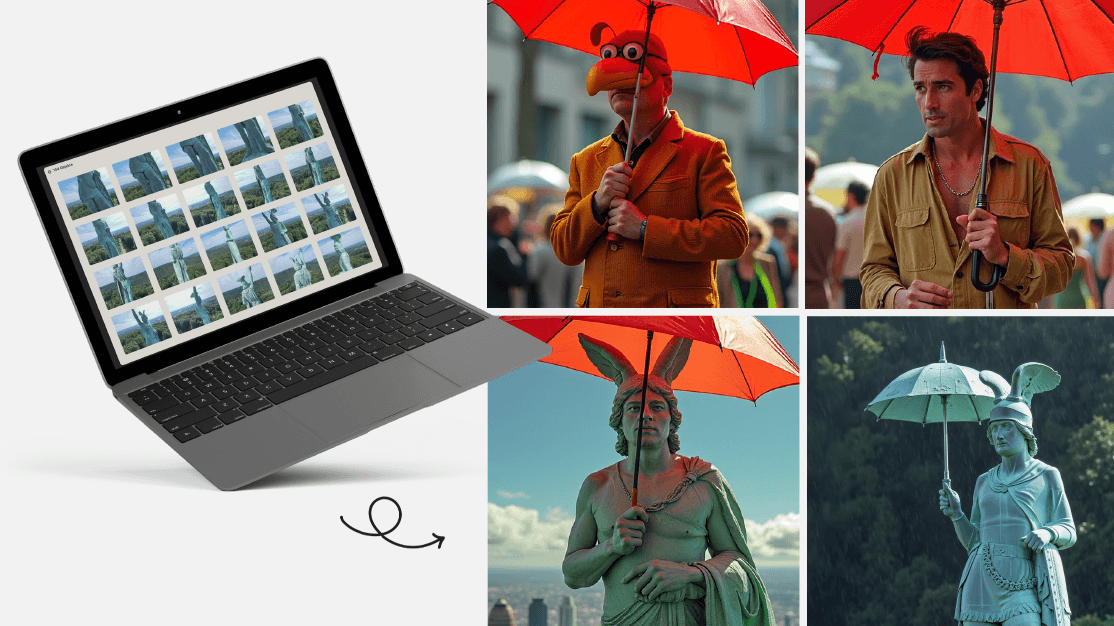

Die Datengrundlage stammte aus zwei Quellen: dem Archiv des Landesverbandes Lippe sowie eigenen Drohnenaufnahmen. In der Regel genügen etwa 30 Bilder, um ein Objekt zu trainieren; bei Personen oft sogar weniger, bei Stilen hingegen mehr. Entscheidend ist die Varianz: unterschiedliche Perspektiven, Lichtverhältnisse und Kontexte. Damit das Modell diese Bilder wirklich „lernen“ konnte, mussten sie verschlagwortet werden – also mit präzisen Bildunterschriften versehen. Wir nutzten hierfür Tools wie kohya_ss und den Flux Gym Trainer, trainiert wurde speziell auf FluxDev, ein Bildgenerierungsmodell von Black Forest Labs.

Warum Bildunterschriften (Captions) dabei so wichtig sind, erklären wir hier.

Damit unser KI-Hermann-LoRA gezielt ansprechbar ist, braucht es ein spezielles Trigger-Wort – ein eigens gewählter Fantasiebegriff, der das Modell eindeutig aktiviert.

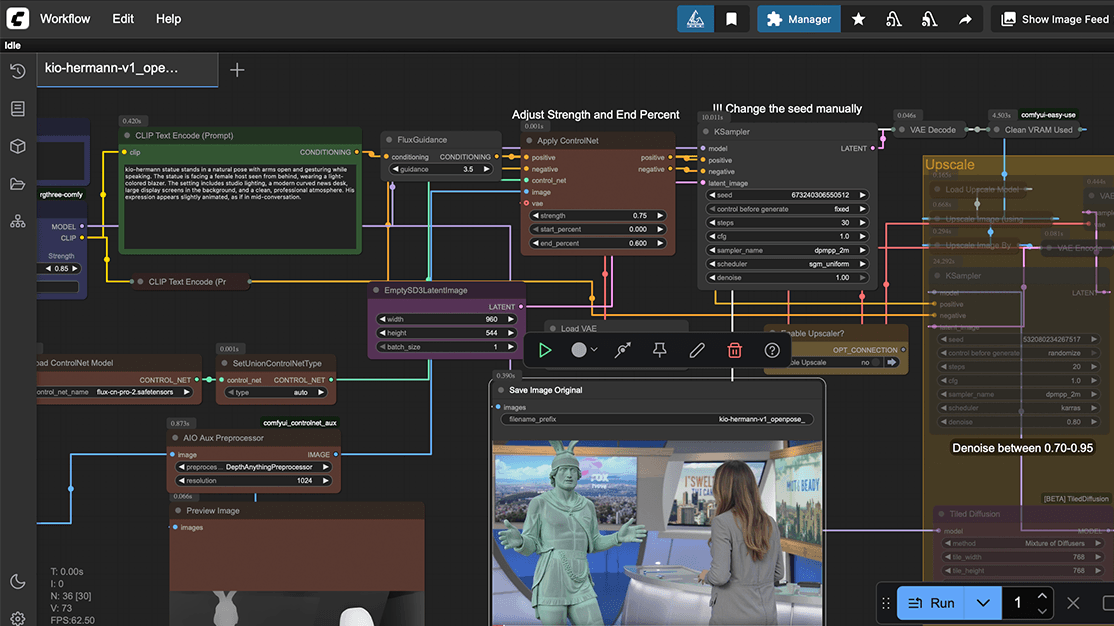

Das trainierte LoRA-Modell wurde anschließend in ComfyUI eingebunden. ComfyUI ist ein mächtiges Open-Source-Tool für Stable Diffusion und Flux-Modelle, das mit einer visuellen, node-basierten Oberfläche arbeitet. Anstatt nur Texte, also Prompts, einzugeben, können hier Workflows modular aufgebaut und Parameter präzise gesteuert werden. Für uns war das ideal: So ließ sich über mehrere Bilder hinweg ein konsistenter Charakter in unterschiedlichen Perspektiven darstellen. Ein weiterer Vorteil: Die Intensität des LoRA-Einsatzes lässt sich flexibel regulieren. Über Zusatz-Nodes wie OpenPose (ControlNet) konnten wir sogar Körperhaltungen oder Bewegungen des Hermanndenkmal in gewünschte Szenarien einfügen.

Im weiteren Produktionsprozess nutzten wir zudem Flux Kontext. Damit konnten wir das Denkmal in verschiedenen Jahreszeiten oder Stimmungen darstellen.

Um zum gewünschten Motiv zu gelangen, waren oft mehrere Generierungen nötig. Prompt oder Parameter mussten wiederholt angepasst werden. Teilweise entwickelten wir die Prompts zunächst in ChatGPT, bevor wir die endgültigen Varianten in ComfyUI erstellten. Heraus kam eine Vielzahl an Bildversionen, von denen wir die besten auswählten und in Photoshop nachbearbeiteten. Für manche Szenen reichten wenige Versuche, andere erforderten 30 oder mehr Iterationen, bis eine überzeugende Komposition stand.

Die Erzeugung eines synthetischen Charakters auf Basis eines realen Vorbilds erfordert mehrere Zwischenschritte – ein einzelner Knopfdruck reicht nicht aus. Zwar weist der „KI-Hermann“ im Vergleich zum Original noch sichtbare Unschärfen und Abweichungen auf – zum Teil bewusst in Kauf genommen –, doch gegenüber klassischen 3D-Renderings wirkt er bereits erstaunlich fotorealistisch, lässt sich deutlich schneller realisieren und überzeugt, solange man bereit ist, gewisse Fehler zu akzeptieren.

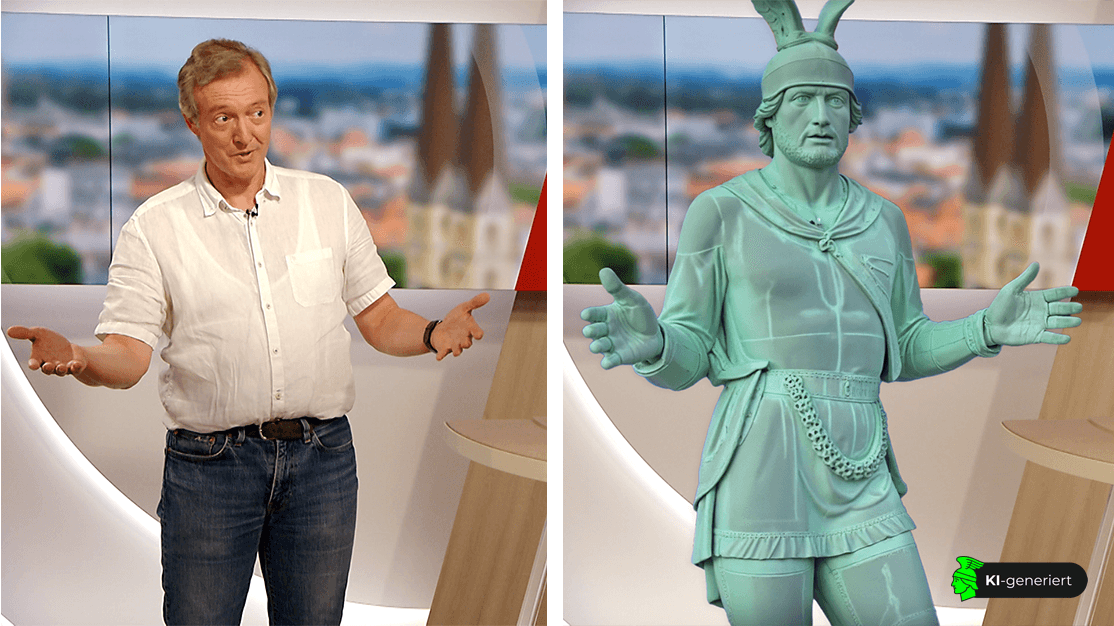

Damit der KI-Hermann nicht nur als Bild, sondern auch in Bewegung sichtbar wird, nutzten wir unter anderem Runway Gen-4, Act-One und Act-Two. Ausgangspunkt war dabei stets ein bereits generiertes Motiv des Hermannsdenkmals in der gewünschten Szene. Dieses Standbild bildete die Grundlage, die anschließend in Bewegung übersetzt wurde.

Runway Gen-4 eignet sich besonders, wenn es darum geht, Figuren und Umgebungen über mehrere Frames hinweg konsistent darzustellen. Kamerafahrten, wechselnde Lichtverhältnisse oder atmosphärische Effekte lassen sich so überzeugend erzeugen. Die Länge der Clips ist aktuell auf etwa5 bis 10 Sekunden begrenzt. Praktisch entstehen dadurch kurze Sequenzen, die wie Bausteine zusammengesetzt werden können. MitGen-4 Turbo lassen sich diese Clips deutlich schneller generieren, was die Arbeitsschleifen verkürzt – denn meist sind mehrere Durchläufe nötig, um ein passendes Ergebnis zu erzielen.

Act-One und Act-Two von Runway nutzen ein ähnliches Prinzip: Eine kurze Live-Aufnahme, zum Beispiel eine Kopfbewegung oder Geste, dient als sogenannte Driving Performance. Diese Bewegungsdaten werden anschließend auf ein Standbild übertragen. Dabei werden die grundlegende Mimik und Gestik realistisch nachgebildet, während feinere Details wie Mikroexpressionen oder subtile Nuancen weniger stark zur Geltung kommen. Dadurch eignen sich Act-One und Act-Two besonders gut, um einfache, ausdrucksstarke Bewegungen auf ein Bild zu übertragen.

Nach der Generierung folgte immer ein zweiter Schritt in der klassischen Postproduktion. In Programmen wie Adobe Premiere undAfter Effects wurden die kurzen Clips geschnitten, farblich abgestimmt und zu längeren Sequenzen kombiniert. Auf diese Weise konnten die zeitlich begrenzten Ausschnitte zu einem stimmigen Gesamtbild erweitert werden.

Ein wichtiger Punkt bleibt die Herkunft der Trainingsdaten. Viele leistungsstarke Video-Modelle wie Runway – ebenso wie Bildgeneratoren etwa von Midjourney oder Flux – sind intransparent, was die verwendeten Datensätze betrifft. Langfristig wäre es wünschenswert, verstärkt mit Plattformen zu arbeiten, die hier andere Standards setzen, etwaMoonvalley, das Wert auf faire und überprüfbare Daten legt (mehr dazu hier). Dennoch ist es bemerkenswert, was aktuell im Bereich der KI-Videogenerierung bereits möglich ist.

KI gilt oft als Abkürzung: Sie spart Zeit, steigert Effizienz und wird vielerorts als Allzweckwerkzeug verstanden. Einiges am Hype ist tatsächlich berechtigt – auch wir haben erlebt, wie generative KI einzelne Arbeitsschritte erstaunlich beschleunigen kann. Doch dabei wird leicht übersehen, dass KI letztlich nur ein anderer, vielleicht neuer Weg ist, Inhalte zu erstellen. In unserem Projekt stand die Content-Produktion im Zentrum, insbesondere visuelle Inhalte. Hier kann KI ein hilfreiches Werkzeug sein, das neue Pfade der Medienproduktion eröffnet und punktuell Zeit sparen kann.

KI ist keine Abkürzung, sondern ein neuer Weg – erfordert aber weiterhin Zeit, Know-how und ein klares Ziel.

Was sie uns jedoch nicht abnimmt – auch wenn es manchmal suggeriert wird – ist das konzeptionelle Denken, das bewusste Entscheiden. Qualität und Konsistenz entstehen nicht per Knopfdruck. Der Feinschliff bleibt Handarbeit. Der Mensch bleibt der Entscheider, der Regisseur, die kreative Instanz. KI gleicht einerSlot Machine: Sie spuckt unzählige Vorschläge aus, aber welche Botschaft vermittelt wird, das liegt weiterhin bei uns. Kommunikation lässt sich nicht automatisieren.

Unser Projekt „KI-Hermann“ hat gezeigt, dass KI längst mehr ist als Spielerei. Gerade in der Bildgenerierung erweist sie sich als ernstzunehmendes Produktionswerkzeug – und die Entwicklungen im Bereich Videogenerierung sind hochspannend zu beobachten. Wer jedoch noch an den Mythos des „Contents auf Knopfdruck“ glaubt, steuert direkt in Beliebigkeit und Austauschbarkeit. KI liefert Rohmaterial – das Gestalten, Schleifen und Verfeinern bleibt Aufgabe des Anwenders.

Und ja, KI ist mächtig. Sie ist multimodal, lässt sich durch Sprache steuern, wirkt intuitiv. Aber wie jedes Werkzeug ist sie ambivalent: Sie kann Neues schaffen und verbessern, aber auch verzerren und verletzen. Der Hammer schlägt Nägel ein – oder zerstört. Genau darin liegt die Verantwortung: nicht nur technische und praktische Fragen zu stellen, sondern auch gesellschaftliche. Wer profitiert von automatisierten Prozessen? Schafft KI Freiraum für Kreativität – oder drängt sie Vielfalt in Standards? Fördert sie neue Stimmen – oder verstärkt vor allem die lautesten?

KI ist nicht neutral. Sie wird von Menschen entwickelt, von Unternehmen vertrieben, von Politik reguliert. Ihre Ergebnisse tragen Daten, Vorannahmen und Machtverhältnisse in sich. Wer die Systeme baut, bestimmt mit, was wir später als „normal“ oder gar „kreativ“ betrachten. Es ist unstrittig, dass KI Arbeit verändert – doch die Verantwortung dafür, wie wir sie einsetzen, bleibt bei uns.

Unser „KI-Hermann“ war ein Experiment. Er zeigt, dass KI neue Möglichkeiten eröffnet, uns zugleich aber herausfordert. Die Arbeit mit diesem Werkzeug zwingt uns, zu fragen, wie wir damit umgehen wollen und welche Verantwortung wir dabei tragen. Nicht, um Technik zu verherrlichen oder zu verdammen, sondern um sie bewusst zu gestalten. Wir glauben nicht, dass KI uns im kreativen Bereich ersetzen wird; sie benötigt immer unseren Input. Was sie hervorbringt, ist letztlich ein Remix bestehender Daten – keine genuin neuen Inhalte. Eigenständig agiert sie nicht: Jeder Output erfordert einen Befehl. Doch genau darin liegt die Konfrontation: KI zwingt uns, unsere Gewohnheiten, unsere Annahmen und unsere Rolle im kreativen Prozess neu zu reflektieren.

Oft wird diskutiert, wie „intelligent“ oder „kreativ“ diese KI-Systeme eigentlich sind. Doch die entscheidendere Frage lautet: Wie intelligent und kreativ gehen wir als Anwender mit ihnen um?

Pressemitteilung

Download